Prometheus e PromQL

O Prometheus é uma ferramenta open-source de monitoramento de sistemas e aplicações que revolucionou a forma de pensar observabilidade em ambientes distribuídos. Ele coleta e armazena métricas como séries temporais, ou seja, valores numéricos associados a um carimbo de tempo e a pares chave-valor chamados labels.

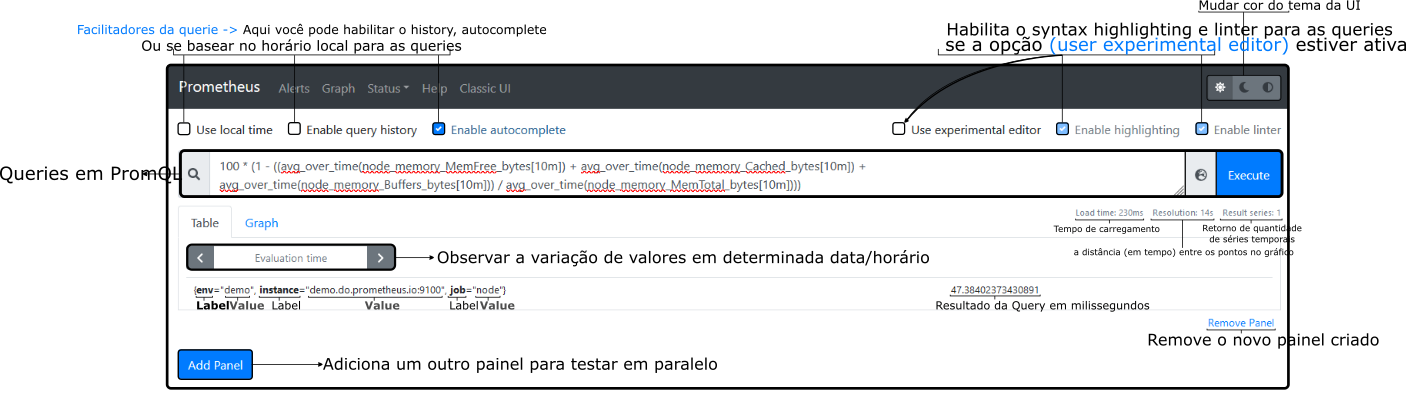

A potência do Prometheus vem, em parte, da sua linguagem de consulta própria, PromQL, que permite criar consultas complexas para analisar os dados coletados em tempo real. A interface web integrada (Expression browser) facilita visualizar e explorar métricas, possibilitando análises rápidas para identificar tendências e anomalias.

Desenvolvido inicialmente na SoundCloud em 2012 por Julius Volz e equipe, o Prometheus foi projetado para ser simples, eficiente e altamente dimensionável. Em 2016, o projeto foi adotado pela Cloud Native Computing Foundation (CNCF) como o segundo projeto hospedado (logo após o Kubernetes), reforçando sua maturidade e ampla adoção pela comunidade.

Hoje, o Prometheus é um pilar no ecossistema de observabilidade cloud-native, frequentemente usado em conjunto com o Grafana para visualizações avançadas, formando uma poderosa stack de monitoramento.

Tipos de métricas

O Prometheus suporta quatro tipos principais de métricas:

-

Counter (Contador): Métrica cumulativa que apenas aumenta (ou zera). Indicada para quantificar eventos, como número de requisições ou erros. Por exemplo, um contador

http_requests_totalincrementa a cada requisição recebida. Contadores nunca diminuem, exceto quando reiniciados. Consultas comuns envolvem a taxa de aumento usando funções comorate()ouincrease(), calculando, por exemplo, quantas requisições por segundo ocorreram em determinado intervalo. -

Gauge (Indicador): Métrica que representa um valor em um instante, podendo tanto aumentar quanto diminuir. Indicado para valores como utilização de CPU, memória ou tamanho de fila – que sobem e descem livremente. Não possui limite mínimo ou máximo fixo. Funções como

avg_over_time(),min(),max()esum()são frequentemente aplicadas sobre gauges para obter médias, mínimos, máximos ou somas ao longo do tempo. -

Histogram (Histograma): Métrica que contabiliza a distribuição de valores observados em buckets (faixas) predefinidos. É muito utilizada para medir latências (e.g., duração de requisiões) ou outros valores cuja distribuição importa. O Prometheus implementa histogramas através de vários contadores – um por bucket – além de contadores especiais para total de observações (

_count) e soma dos valores (_sum). Consultas tipicamente usamhistogram_quantile()para extrair percentis a partir dos buckets e funções comorate()ouincrease()nos contadores para ver taxas. -

Summary (Sumário): Métrica similar ao histograma, mas os cálculos de percentis e médias são feitos pelo próprio alvo instrumentado. O summary fornece diretamente percentis (por exemplo, latência p95) e contagens/agregados para um conjunto de observações. Entretanto, summaries têm a limitação de não poderem ser agregados facilmente entre múltiplas instâncias (diferente dos histogramas). Em geral, histogramas são preferidos para métricas de latência quando se quer combinar valores de várias fontes, enquanto summaries podem ser úteis para percentis muito específicos em instâncias isoladas.

Use Histogramas quando precisar agregar latências de múltiplas instâncias e calcular percentis globais. Use Sumários quando os percentis calculados no cliente são suficientes e a agregação não é necessária.

Além desses tipos principais, o Prometheus expõe métricas especiais de estado – por exemplo, a métrica interna up indica se um determinado alvo foi coletado com sucesso (valor 1) ou não (0). Essa métrica é muito útil para monitorar disponibilidade de serviços: se um endpoint monitorado ficar indisponível, up{instance="endpoint:porta"} == 0 sinaliza falha. Vale notar que não existe um “tipo” separado para essas métricas de saúde; elas normalmente são gauges (0 ou 1) usadas para esse propósito.

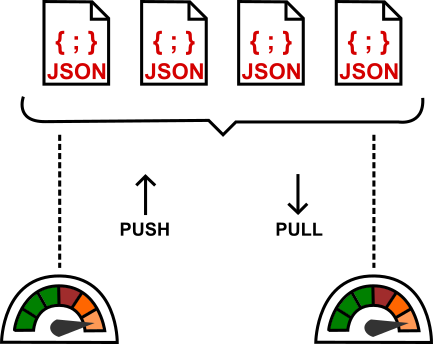

Monitoramento pull vs push

Para entender pull vs push, imagine cuidar de plantas: no modelo pull você vai todo dia verificar se precisam de água; no modelo push as próprias plantas enviam um sinal quando precisam ser regadas. Tecnicamente, no monitoramento pull um sistema central (como o Prometheus) consulta periodicamente os alvos para coletar métricas – ele “puxa” as informações. Já no monitoramento push, os próprios alvos enviam (empurram) as métricas para um coletor central sem serem solicitados.

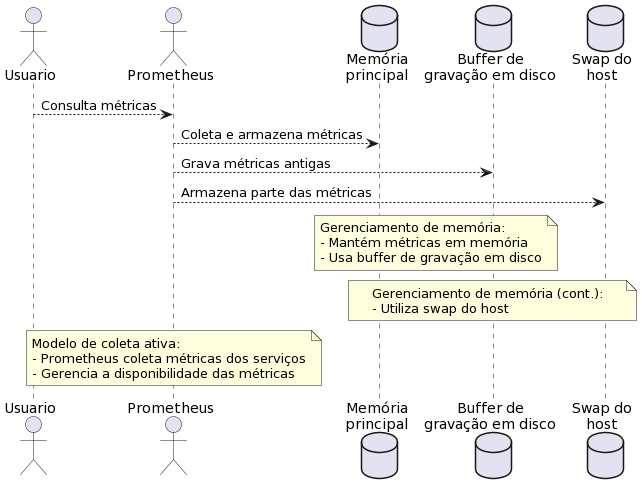

No Prometheus, prevalece o modelo pull. O servidor Prometheus periodicamente faz scrape (raspagem) dos dados de cada alvo exportador via HTTP, no endpoint padrão /metrics. Cada scrape coleta o valor atual de todas as séries expostas naquele alvo.

Os alvos podem ser aplicações instrumentadas que expõem suas métricas diretamente, ou exporters (exportadores) que traduzem métricas de sistemas externos para o formato do Prometheus.

Assim, o Prometheus obtém em intervalos regulares (por padrão a cada 15s) as métricas atuais de cada serviço, armazenando-as localmente.

Na imagem acima, a comparação dos modelos de coleta: à esquerda, no modo push os clientes enviam suas métricas proativamente a um gateway; à direita, no modo pull o Prometheus consulta cada cliente periodicamente. O modelo pull tem vantagens em simplicidade e confiabilidade – se um serviço cair, o Prometheus sabe (a métrica up fica 0) e não depende de buffers intermediários.

Já o modelo push pode ser útil para casos específicos, como jobs de curta duração ou ambientes onde não é possível expor um endpoint (nesses casos usa-se o Pushgateway, discutido adiante). Em suma, o Prometheus, por padrão, não recebe métricas ativamente; ele mesmo vai coletá-las, evitando sobrecarga nos aplicativos monitorados e detectando automaticamente indisponibilidades.

Arquitetura do Prometheus

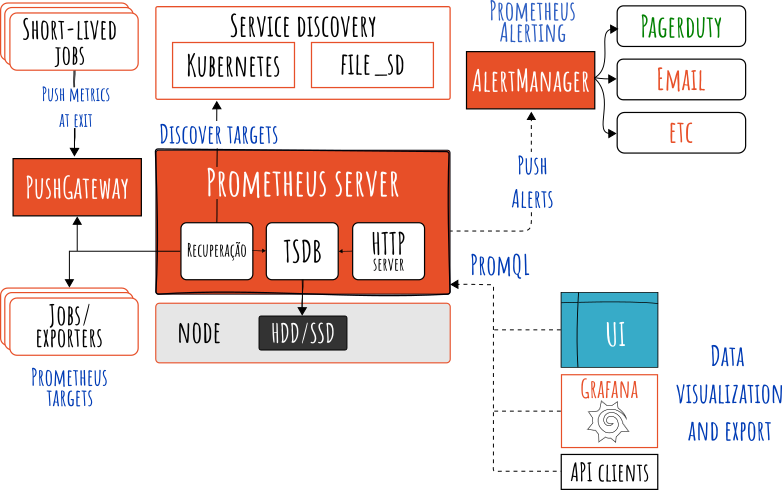

A arquitetura do Prometheus foi concebida para facilitar a coleta de dados de múltiplas fontes de forma confiável e distribuída. O coração do sistema é o Prometheus Server principal, responsável por agendar e realizar as coletas (scrapes) de cada alvo monitorado e armazenar as séries temporais resultantes localmente.

A configuração dessas coletas é definida em um arquivo YAML (geralmente prometheus.yml), especificando jobs e targets – por exemplo, “coletar métricas do serviço X na URL Y a cada 15 segundos”. A figura abaixo (extraída da documentação oficial) ilustra a arquitetura e os componentes do ecossistema Prometheus:

Em resumo, o fluxo é: o Prometheus coleta (pull) métricas dos jobs instrumentados, diretamente dos serviços ou via um componente intermediário de push para jobs efêmeros. Todos os samples coletados são armazenados localmente no banco de dados de séries temporais embutido (TSDB).

Regras definidas podem ser executadas continuamente sobre esses dados – seja para gravar novas séries agregadas (recording rules) ou para acionar alertas. Os alertas gerados pelo Prometheus são então enviados para o Alertmanager processar. Por fim, ferramentas de visualização como o Grafana podem consultar o Prometheus para exibir dashboards das métricas coletadas.

O ecossistema Prometheus possui diversos componentes (muitos opcionais) que interagem nessa arquitetura:

- Servidor Prometheus – o servidor principal que coleta e armazena as métricas e processa consultas PromQL.

- Bibliotecas cliente – usadas para instrumentar código de aplicações (expondo métricas via /metrics). Há libs oficiais em Go, Java, Ruby, Python, etc.

- Exporters – programas externos que coletam métricas de serviços ou sistemas terceiros (bancos de dados, servidores web, sistemas operacionais) e as expõem no formato Prometheus. Exemplos: Node Exporter (métricas de sistema Linux), Blackbox Exporter (monitoramento de endpoints externos), etc.

- Pushgateway – gateway para receber métricas pushed por aplicativos de curta duração ou ambientes onde não dá para o Prometheus puxar diretamente.

- Alertmanager – componente responsável por receber alertas enviados pelo Prometheus e gerenciar o envio de notificações (email, Slack, PagerDuty etc.), realizando agrupamento, deduplicação e silenciamento conforme configurado.

- Ferramentas de suporte – englobam utilitários de linha de comando (como o promtool), exportadores de terceiros, dashboards pré-configurados, entre outros, que facilitam operar e integrar o Prometheus.

Essa arquitetura descentralizada (com coleta pull e componentes distintos) torna o Prometheus especialmente adequado a ambientes modernos com microsserviços e orquestração de contêineres (Docker, Kubernetes).

Ele foi projetado para funcionar de forma autônoma em cada nó (cada servidor Prometheus é independente, sem dependência de armazenamento distribuído), privilegiando confiabilidade mesmo durante falhas de rede ou de outros serviços. Em caso de problemas graves na infraestrutura, você ainda consegue acessar métricas recentes localmente no Prometheus, que atua como fonte de verdade para diagnosticar incidentes.

Labels e Samples

No Prometheus, labels (rótulos) e samples (amostras) são conceitos-chave para organizar os dados monitorados.

Uma analogia simples: imagine um guarda-roupa onde cada roupa tem etiquetas indicando cor, tamanho e tipo. Essas etiquetas ajudam a encontrar rapidamente, por exemplo, “camisetas verdes tamanho M”.

Da mesma forma, no Prometheus cada métrica pode ter vários labels (chave=valor) que a qualificam.

Por exemplo, uma métrica app_memory_usage_bytes poderia ter labels como host="servidor1" e region="us-east". Assim podemos filtrar/consultar “uso de memória no servidor1” apenas buscando por host="servidor1".

Os labels permitem um modelo de dados multidimensional – ou seja, uma mesma métrica (ex: http_requests_total) é armazenada separadamente para cada combinação de labels (rota="/login", método=“GET”, código=“200”, etc.). Isso enriquece as análises, pois podemos agregar ou dividir métricas por essas dimensões conforme necessário.

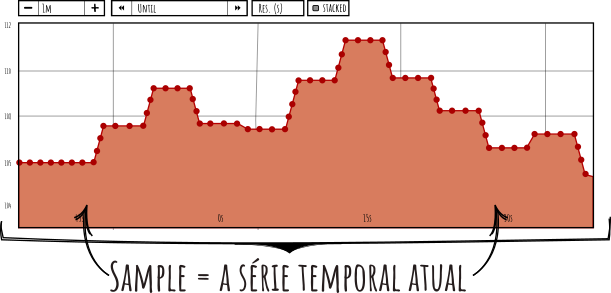

Já os samples são as unidades de dado coletadas ao longo do tempo – cada medição individual de uma métrica em um determinado instante.

Voltando à analogia, se pedíssemos a cada criança numa pesquisa que escolhesse 3 balas, as balas escolhidas por cada criança seriam uma amostra da preferência de balas.

No contexto do Prometheus, a cada scrape o valor de cada métrica coletada é um sample (com timestamp e valor). Esses samples ficam armazenados como uma série temporal etiquetada, permitindo ver a evolução daquele valor no tempo.

Por exemplo, considere a métrica gauge node_cpu_usage com label host. Para cada host monitorado, teremos uma série separada, e a cada intervalo de coleta obtemos um sample novo do uso de CPU daquele host. Assim, podemos consultar a série para ver como a CPU variou ao longo de um dia inteiro para cada máquina.

Exemplo de séries temporais no Prometheus: cada ponto representa um sample (valor observado) etiquetado por instância ou outra dimensão, armazenado em sequência temporal.

Em resumo, labels fornecem contexto (quem, onde, o quê) e samples fornecem o valor numérico no tempo. Essa combinação é o que torna o Prometheus poderoso para agregar métricas semelhantes e, ao mesmo tempo, permitir recortes por dimensão. Vale ressaltar a importância de escolher labels com cardinalidade controlada – ou seja, evitar labels que possam assumir valores extremamente variados (como IDs únicos, URLs completas ou timestamps).

Nota: Labels com variação descontrolada podem causar uma explosão de séries e sobrecarregar o Prometheus, conforme discutiremos em melhores práticas.

Instalação

Existem diversas maneiras de instalar e executar o Prometheus. Aqui vou demonstrar uma configuração simples usando Docker e Docker Compose, incluindo o Grafana e uma ferramenta de simulação de métricas chamada PromSim (útil para testes). Essa stack de exemplo traz:

- Prometheus – servidor de métricas.

- Grafana – para dashboards e visualização.

- PromSim – um simulador que expõe métricas aleatórias para exercitar o Prometheus.

Comece criando um arquivo docker-compose.yml com o seguinte conteúdo:

version: "3"

services:

prometheus:

image: prom/prometheus:latest

container_name: prometheus

ports:

- "9090:9090"

volumes:

- "./prometheus.yml:/etc/prometheus/prometheus.yml"

depends_on:

- promsim

grafana:

image: grafana/grafana:latest

container_name: grafana

ports:

- "3000:3000"

promsim:

image: sysdigtraining/promsim:latest

container_name: promsim

ports:

- "8080:8080"No mesmo diretório, crie o arquivo de configuração prometheus.yml para o Prometheus:

global:

scrape_interval: 15s

evaluation_interval: 15s

scrape_configs:

- job_name: "promsim"

static_configs:

- targets: ["promsim:8080"]Esse arquivo define que o Prometheus fará scrape a cada 15s (scrape_interval) e avalia regras na mesma frequência (evaluation_interval). Em scrape_configs, temos um job chamado “promsim” que coleta métricas do endereço promsim:8080 (nosso container PromSim simulando um alvo de métricas). Agora suba os serviços:

docker-compose up -dIsso iniciará os containers Prometheus, Grafana e PromSim em segundo plano. Após o start, acesse o Grafana em http://localhost:3000 (usuário admin, senha admin padrão). No Grafana, adicione o Prometheus como fonte de dados: vá em Configuration (engrenagem) > Data Sources, adicione nova fonte do tipo Prometheus com URL http://prometheus:9090 (que, devido ao Docker Compose, resolve para o container do Prometheus).

Feito isso, você já pode importar ou criar painéis Grafana usando as métricas do Prometheus (inclusive as geradas pelo PromSim). O PromSim estará expondo várias métricas aleatórias – por exemplo, simulando CPU, memória, requisições – permitindo testar consultas e alertas sem precisar de uma aplicação real por trás. Para mais detalhes do PromSim, veja a documentação oficial.

Caso queira rodar apenas o Prometheus isoladamente, basta executar o container oficial: docker run -p 9090:9090 prom/prometheus. Depois acesse http://localhost:9090 para abrir a UI nativa do Prometheus:

A interface web padrão do Prometheus inclui os seguintes menus no topo:

- Alerts: lista os alertas ativos e suas informações. Mostra também alertas pendentes e silenciados.

- Graph: permite rodar consultas PromQL e visualizar o resultado em formato gráfico (ou tabela). É útil para explorar interativamente as métricas.

- Status: informações sobre o status do servidor Prometheus – memória usada, número de séries ativas, status das coletas, etc.

- Targets (na seção Status): mostra todos os alvos configurados e se a coleta está OK (up) ou falhou.

- Service Discovery (também em Status): lista os serviços descobertos via mecanismos dinâmicos (Kubernetes, DNS, etc.).

- Help: link para documentação e ajuda do Prometheus.

Além disso, logo abaixo dos menus, a UI oferece algumas opções e campos importantes:

- Time range e refresh: controles para selecionar o intervalo de tempo da consulta e atualizar automaticamente.

- Use local time: alterna entre exibir os timestamps no seu fuso horário local ou em UTC.

- Query history: opção para habilitar histórico das consultas feitas (facilita repetir queries recentes).

- Autocomplete: opção para habilitar auto-completar de métricas e funções no campo de consulta.

- Campo de consulta PromQL: onde você escreve a expressão a ser consultada. O Prometheus traz sugestões enquanto você digita (se autocomplete ligado).

- Botões Execute / Reset: para executar a consulta ou limpar o campo.

- Aba Graph / Table: seleciona se o resultado será plotado em um gráfico ou mostrado como tabela bruta de valores.

- Evaluation time: permite fixar um timestamp específico para avaliar a query (por padrão é “now”, mas você pode ver valores históricos escolhendo um horário passado).

Dica: a UI do Prometheus é ótima para explorar e depurar métricas rapidamente, mas para dashboards permanentes e mais bonitos geralmente usamos o Grafana. O Grafana se conecta ao Prometheus via API e permite combinar múltiplas consultas em gráficos customizados.

Configuração

Após instalar, o principal arquivo a ajustar é o de configuração do Prometheus (prometheus.yml). Nele definimos os parâmetros globais, jobs de scrape, regras de alerta, etc. Vamos examinar a estrutura básica e algumas customizações comuns. Um exemplo mínimo de prometheus.yml poderia ser:

global:

scrape_interval: 15s

scrape_configs:

- job_name: 'prometheus'

static_configs:

- targets: ['localhost:9090']Nesse caso, definimos um intervalo global de scrape de 15s e um job para monitorar o próprio Prometheus (expondo métricas em localhost:9090). Para monitorar outras aplicações, adicionamos novos blocos em scrape_configs. Por exemplo, para monitorar uma aplicação web rodando na porta 8080 de um host chamado my-app:

scrape_configs:

- job_name: 'my-app'

static_configs:

- targets: ['my-app:8080']Isso instruirá o Prometheus a coletar periodicamente métricas em http://my-app:8080/metrics. Podemos repetir o processo para cada serviço ou componente que queremos incluir, definindo um job_name descritivo e a lista de endpoints (targets).

Para ambientes com muitos alvos ou infraestrutura dinâmica, é inviável gerenciar esses targets manualmente. Nesses casos, o Prometheus oferece integrações de Service Discovery (Kubernetes, AWS EC2, Consul, DNS, etc.) e também o file-based discovery (descoberta via arquivos).

Este último permite apontar para um ou mais arquivos JSON externos contendo a lista de targets. Assim, ferramentas externas ou scripts podem atualizar esses arquivos conforme os serviços mudam, e o Prometheus percebe as alterações automaticamente. Por exemplo, poderíamos alterar o job acima para usar arquivo:

scrape_configs:

- job_name: 'my-app'

file_sd_configs:

- files:

- /etc/prometheus/targets/my-app.jsonE no arquivo /etc/prometheus/targets/my-app.json colocar algo como:

[

{

"labels": {

"job": "my-app",

"env": "production"

},

"targets": [

"my-app1:8080",

"my-app2:8080"

]

}

]Nesse JSON, especificamos dois targets (dois instâncias da aplicação my-app) e também atribuímos labels adicionais a essas instâncias (env: production, por exemplo). Assim, se futuramente adicionarmos my-app3:8080, basta atualizar o JSON – o Prometheus recarrega periodicamente ou quando o arquivo muda. Esse método facilita escalabilidade e automação da configuração de alvos.

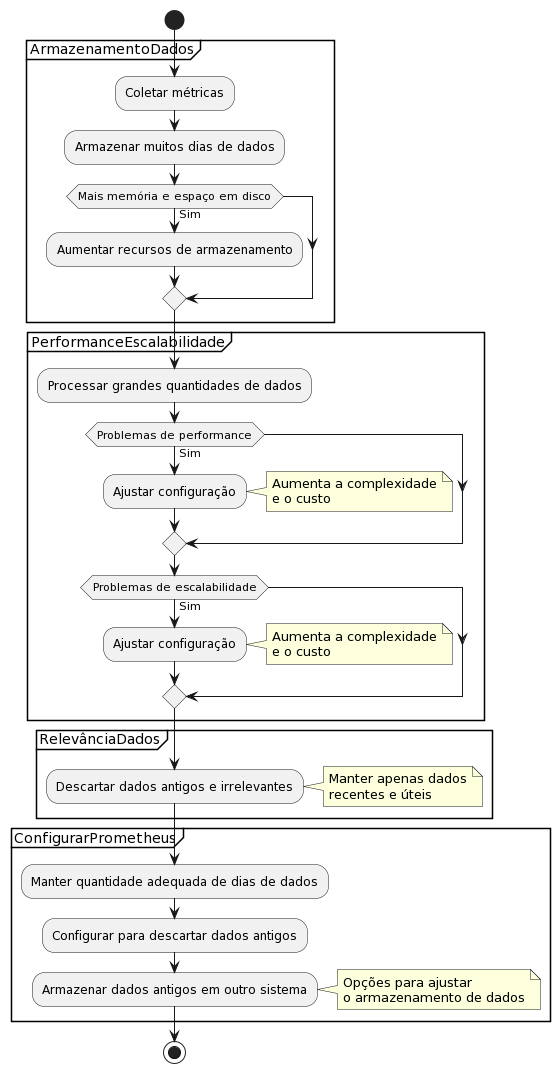

Outro ponto de configuração importante é a retenção de dados. Por padrão, o Prometheus guarda as séries temporais localmente por 15 dias. Em ambientes de produção, pode ser necessário ajustar esse período.

Você pode definir a flag de inicialização --storage.tsdb.retention.time (ou configurar no serviço) para algo maior, por exemplo 30d para reter ~1 mês de métricas. Tenha em mente que aumentar a retenção aumenta proporcionalmente o consumo de disco e memória.

Também é possível limitar por tamanho de disco (--storage.tsdb.retention.size), se preferir. Caso precise de retenção muito longa (meses/anos), é recomendável integrar com soluções de armazenamento remoto em vez de manter tudo no Prometheus (falaremos disso em Melhores Práticas).

Exemplo de definição de retenção no systemd (ExecStart):

/opt/prometheus/prometheus \

--config.file=/opt/prometheus/prometheus.yml \

--storage.tsdb.retention.time=30dNota: O formato aceita unidades como

h,d,w,y. Você também pode usar a opção--storage.tsdb.retention.sizepara definir um tamanho máximo (por ex:50GB), o que ocorrer primeiro (tempo ou tamanho) aciona a limpeza de dados antigos.

Em instalações via pacote ou container, normalmente a estrutura de diretórios do Prometheus é assim:

/opt/prometheus/

├── prometheus (binário)

├── promtool (binário utilitário)

├── prometheus.yml (configuração)

├── consoles/ (arquivos HTML da UI "classic")

├── console_libraries/ (bibliotecas JS para consoles)

└── data/ (armazenamento local das séries temporais)A pasta data/ merece destaque – ali ficam todos os dados das métricas coletadas. Abordaremos sua estrutura interna na seção “Under the Hood”.

Em resumo, após instalar, você deve editar o

prometheus.ymlpara incluir todos os targets que deseja monitorar (seja listando estaticamente ou via mecanismos dinâmicos) e ajustar parâmetros globais (intervalos, regras, retenção).

Depois reinicie o serviço/container do Prometheus para aplicar as alterações. Para validar se a sintaxe do arquivo está correta antes de reiniciar, podemos usar o promtool conforme abaixo.

🔍 Instrumentação

A instrumentação é o processo de inserir coleta de métricas em sistemas e aplicações. No contexto Prometheus, podemos dividir em dois tipos:

📊 Instrumentação direta (na aplicação)

Significa instrumentar o próprio código da aplicação ou serviço para expor métricas de negócio ou de desempenho relevantes. Você adiciona pontos de métrica no código (counters, gauges, etc.) usando uma biblioteca cliente do Prometheus.

Assim, a própria aplicação passa a expor um endpoint /metrics com dados em tempo real sobre si mesma (latência de requisições, uso de memória interno, tamanho de fila, etc.).

Essa abordagem dá controle granular – os desenvolvedores escolhem o que medir – e tende a fornecer métricas altamente específicas e úteis para diagnosticar o comportamento da aplicação.

🔄 Instrumentação indireta (via exporters)

Refere-se a coletar métricas de sistemas externos ou legados através de componentes intermediários chamados exporters. Em vez de modificar o sistema alvo, você roda um exporter que coleta informações daquele sistema (geralmente via APIs existentes, comandos ou leitura de arquivos) e as expõe no formato Prometheus.

O Prometheus então faz scrape nesse exporter. Essa abordagem é comum para: sistemas operacionais, bancos de dados, servidores web, ou qualquer software que não tenha suporte nativo ao Prometheus.

Por exemplo, há exporters para MySQL, PostgreSQL, Apache/Nginx, Redis, entre muitos outros, que traduzem métricas desses sistemas para o formato esperado.

Ambos os tipos são importantes. A instrumentação direta fornece métricas sob medida da aplicação (por exemplo, quantas transações processou, quantos usuários ativos, etc.), enquanto a indireta garante visibilidade de componentes de infraestrutura e softwares de terceiros sem precisar alterar eles.

A seguir, veremos exemplos de instrumentação indireta (principais exporters) e de instrumentação direta em algumas linguagens.

Instrumentação indireta: Exporters

Ecossistema nativo: O Prometheus já oferece diversos exporters oficiais ou mantidos pela comunidade para sistemas populares. Alguns exemplos:

-

Node Exporter (Linux): Coleta métricas de sistema operacional Linux – CPU, memória, disco, rede, entropia, stats de kernel, etc. É imprescindível para monitorar VMs ou servidores bare metal. Basta executar o binário do node_exporter no host; ele abre :9100/metrics com dezenas de métricas padronizadas (cpu_seconds_total, node_filesystem_usage_bytes, etc.). Essas métricas dão uma visibilidade completa do estado do host, permitindo identificar gargalos de recurso.

-

Windows Exporter (Windows): Equivalente para plataformas Windows (antigo WMI exporter). Coleta CPU, memória, disco, contadores do Windows, etc., expondo em :9182/metrics (porta padrão). Assim, ambiente heterogêneos também podem ser monitorados.

-

Blackbox Exporter: Útil para monitorar externamente a disponibilidade de serviços. Ele executa probes do tipo ICMP (ping), HTTP(S), DNS, TCP, etc., simulando a experiência do usuário externo. Você configura módulos de probe (ex: checar HTTP 200 em determinada URL dentro de 2s) e o Prometheus chama o Blackbox passando o alvo a testar. Se a resposta falha ou excede tempo, métricas como

probe_success=0 ouprobe_duration_secondsindicam problema. É excelente para monitorar uptime de sites e endpoints de fora para dentro. -

Exporters de aplicações: Há muitos: PostgreSQL exporter, Redis exporter, JMX exporter (Java), SNMP exporter (equipamentos de rede), etc. Em geral, se você usar alguma tecnologia popular, provavelmente já existe um exporter pronto (a documentação oficial lista dezenas: Exporters e integrações).

Como usar exporters? Normalmente é executar o binário do exporter próximo do serviço alvo, e então adicionar um job no

prometheus.ymlapontando para o endpoint do exporter. Por exemplo, para Node Exporter em várias máquinas, você rodaria node_exporter em cada host (porta 9100) e adicionaria algo como:

scrape_configs:

- job_name: 'node'

static_configs:

- targets: ['host1:9100', 'host2:9100', ...]Assim o Prometheus coletará as métricas de cada máquina. Cada métrica virá automaticamente com labels como instance="host1:9100" e outras específicas (o Node Exporter adiciona label job="node" e por vezes labels como cpu="0" para métricas por CPU, etc.).

Em resumo, a instrumentação indireta via exporters é fundamental para trazer para o Prometheus dados de componentes que não expõem nativamente as métricas. É um jeito de bridge (ponte) entre sistemas legados e o moderno mundo do Prometheus.

Configuração Avançada

Discovery Dinâmico e Relabeling

Em ambientes modernos com infraestrutura dinâmica (Kubernetes, cloud, microsserviços), configurar targets manualmente no prometheus.yml torna-se inviável. O Prometheus oferece mecanismos de Service Discovery que permitem descobrir automaticamente alvos para monitoramento, e o Relabeling permite transformar dinamicamente essas descobertas durante o processo de configuração.

Service Discovery

O Prometheus suporta diversos mecanismos de descoberta automática:

- Kubernetes: Descobre pods, serviços, endpoints automaticamente baseado em labels e anotações.

- AWS EC2: Encontra instâncias EC2 baseado em tags.

- Consul: Usa o Consul como fonte de verdade para serviços.

- DNS: Resolve nomes DNS para descobrir alvos.

- File-based: Lê targets de arquivos JSON/YAML que podem ser atualizados externamente.

Exemplo de discovery Kubernetes:

scrape_configs:

- job_name: 'kubernetes-pods'

kubernetes_sd_configs:

- role: pod

relabel_configs:

- source_labels: [__meta_kubernetes_pod_annotation_prometheus_io_scrape]

action: keep

regex: true

- source_labels: [__meta_kubernetes_pod_annotation_prometheus_io_path]

action: replace

target_label: __metrics_path__

regex: (.+)

- source_labels: [__address__, __meta_kubernetes_pod_annotation_prometheus_io_port]

action: replace

regex: ([^:]+)(?::\d+)?;(\d+)

replacement: $1:$2

target_label: __address__Relabeling

O relabeling é uma funcionalidade poderosa que permite transformar labels, nomes de targets, endereços e outros metadados durante o processo de discovery. É fundamental para:

- Filtrar targets indesejados (ex: excluir pods de teste)

- Adicionar/remover labels dinamicamente

- Transformar endereços (ex: mascarar IPs internos)

- Agrupar targets logicamente

Exemplo prático de relabeling:

relabel_configs:

# Manter apenas pods com annotation prometheus.io/scrape=true

- source_labels: [__meta_kubernetes_pod_annotation_prometheus_io_scrape]

action: keep

regex: true

# Extrair namespace como label

- source_labels: [__meta_kubernetes_namespace]

action: replace

target_label: namespace

# Adicionar label de ambiente baseado no namespace

- source_labels: [namespace]

regex: 'prod-.*'

replacement: 'production'

target_label: environment

# Remover porta padrão se não especificada

- source_labels: [__address__]

regex: '(.+):8080'

target_label: instance

replacement: '$1'

# Filtrar targets que começam com 'test'

- action: drop

source_labels: [__meta_kubernetes_pod_name]

regex: 'test.*'Casos de uso comuns:

- Filtros de ambiente: Manter apenas pods de produção, excluindo dev/test

- Mascaramento de dados sensíveis: Remover IPs internos ou informações de debug

- Agregação por labels: Agrupar targets por região, datacenter, time

- Normalização de nomes: Padronizar nomes de instâncias ou serviços

Importante: O relabeling é aplicado antes do scrape, então você pode usar

__meta_*labels (metadados do discovery) para tomar decisões sobre quais targets monitorar e como rotulá-los.

PromQL: Os Fundamentos

PromQL é a linguagem de consulta poderosa usada pelo Prometheus para extrair dados de métricas e configurar alertas. Seu principal objetivo é possibilitar a análise e monitoramento de métricas (como requisições HTTP por segundo ou a média de utilização de CPU por servidor) por meio de expressões que definem cálculos específicos.

O PromQL suporta funções matemáticas, operações booleanas e de comparação, além de agrupamento de dados e agregações. Ela também conta com recursos avançados, como subconsultas e funções de análise temporal.

As consultas PromQL podem ser executadas através da interface web do Prometheus, de APIs ou de bibliotecas de clientes. Em resumo, a PromQL é essencial para monitorar e analisar o desempenho de sistemas com eficiência e precisão.

A linguagem também possibilita a criação de gráficos e painéis de visualização para métricas, utilizando ferramentas como o Grafana. Desta forma, a PromQL se mostra fundamental para obter insights rápidos sobre o comportamento de aplicações e infraestruturas.

Nesta seção, vamos explorar os fundamentos da PromQL — incluindo seletores, tipos de vetores e operadores básicos — e demonstrar como criar consultas simples para analisar dados de métricas.

Time Series Database (TSDB)

O Prometheus armazena os dados em um formato binário chamado TSDB (Time Series Database). O TSDB é um banco de dados de séries temporais otimizado para armazenar métricas de forma eficiente.

Para simplificar o entendimento, imagine que você tem um diário onde registra, todos os dias e nos mesmos horários, informações como a temperatura do ar, velocidade do vento e pressão atmosférica.

Essas informações são armazenadas em ordem cronológica (por tempo) e podem ser consultadas para ver como variam ao longo do tempo. Essa é a essência de um banco de dados de série temporal: armazenar e consultar dados que possuem uma dimensão temporal.

Monitorar métricas a partir de um banco de dados de séries temporais traz várias vantagens:

- Análise histórica: Por armazenar dados em ordem cronológica, é possível analisar tendências e padrões ao longo do tempo. Isso ajuda a entender como o desempenho do sistema evolui e identificar tendências que possam indicar problemas futuros.

- Identificação de problemas: Com dados históricos, podemos investigar incidentes passados para identificar causas raiz de problemas de desempenho ou disponibilidade.

- Alertas baseados no tempo: Dados históricos permitem criar alertas que consideram tendências temporais, como alertar quando um recurso tem desempenho abaixo do normal em horários específicos ou quando há tendências de crescimento preocupantes.

- Armazenamento escalável: Bancos de dados de séries temporais são projetados para lidar com grandes volumes de dados e escalar horizontalmente, permitindo armazenar métricas sem perda de desempenho.

- Integração com outras ferramentas: A maioria das ferramentas de monitoramento suporta a coleta de dados de TSDBs, facilitando a integração com diversos sistemas de análise e observabilidade.

Em resumo, usar um banco de dados de série temporal permite coletar, armazenar e analisar dados de métricas de desempenho ao longo do tempo, possibilitando identificar problemas, tendências e padrões com facilidade.

O PromQL (Prometheus Query Language) é a linguagem usada para consultar essas métricas armazenadas no Prometheus. Com o PromQL, os usuários criam consultas complexas para extrair informações acionáveis das métricas. Algumas capacidades importantes do PromQL incluem:

- Funções de agregação: Permitem resumir dados ao longo do tempo ou por categorias, como média, soma, máximo e mínimo. Por exemplo, podemos usar

avg()para calcular a média de uma métrica ao longo de um período. - Funções de filtragem: Permitem selecionar subconjuntos das métricas com base em critérios. Por exemplo, podemos usar seletores para filtrar por rótulos (labels) específicos, como pegar apenas métricas de um serviço ou data center específico.

- Funções de transformação: Permitem transformar os dados brutos em valores mais úteis. Por exemplo, a função

rate()calcula a taxa de mudança de um contador (como número de requisições por segundo) a partir da diferença entre dois pontos no tempo.

PromQL também suporta operações matemáticas básicas (adição, subtração, multiplicação e divisão) para combinar métricas ou ajustar seus valores. Além disso, permite o uso de operadores lógicos (como and e or) para combinar expressões e criar consultas ainda mais complexas.

Recursos avançados, como uso de rótulos (labels) para selecionar séries específicas e subconsultas aninhadas, tornam a PromQL uma linguagem poderosa e flexível. A seguir, exploraremos em detalhes esses conceitos e como utilizá-los na prática.

Seletores de métricas

Os seletores em PromQL funcionam como filtros que permitem escolher uma ou mais séries de métricas específicas para consulta. Existem dois tipos principais de seletores:

- Seletor por nome de métrica: Seleciona séries pelo nome da métrica. Por exemplo,

http_requests_totalretorna todas as séries temporais cuja métrica tenha esse nome. - Seletor por label: Seleciona séries com base em um ou mais labels (rótulos) e seus valores. Por exemplo, se uma métrica

http_requests_totalpossui os labelsmethodehandler, podemos filtrar pelas séries ondemethod="GET"ehandler="/api/v1/users"escrevendo:

http_requests_total{method="GET", handler="/api/v1/users"}Para combinar seletores de label, usamos operadores de correspondência (matchers) como =, !=, =~ (regex correspondente) e !~ (regex negativa). Esses operadores servem para comparar valores de labels (ou aplicar expressões regulares) ao selecionar as séries desejadas. Veja alguns exemplos:

- Selecionar todas as métricas cujo nome começa com “http”:

{__name__=~"http.*"}Aqui, usamos o label especial __name__ (que representa o nome da métrica) com uma expressão regular para corresponder qualquer métrica cujo nome comece com “http”.

- Selecionar séries que possuem o label

statuscom valor exatamente “error”:

{status="error"}- Selecionar séries que possuem o label

appcom valor “frontend” ou “backend”:

{app=~"frontend|backend"}Nesse caso, o operador regex =~ com o padrão frontend|backend faz o seletor pegar séries cujo label app seja “frontend” ou “backend”.

Ao usar expressões regulares em seletores, é importante ter cuidado para não selecionar séries indesejadas. Por exemplo, um seletor como {job=~"prom.*"} traria todas as séries cujos labels job começam com “prom” — isso poderia incluir séries que não eram o alvo pretendido (como um job auxiliar relacionado).

Portanto, sempre procure ser o mais específico possível nos seletores para evitar correspondências acidentais.

Tipos de expressões em PromQL

PromQL oferece vários tipos de expressões para manipular as séries temporais coletadas pelo Prometheus. As principais incluem:

- Expressões aritméticas: Realizam cálculos matemáticos entre séries de métricas ou entre séries e constantes. Por exemplo, podemos somar duas métricas (

metric_a + metric_b), subtrair (metric_a - metric_b), multiplicar (metric_a * 100para converter em porcentagem), etc. Exemplo:

node_cpu_seconds_total{mode="system"} / node_cpu_seconds_total{mode="idle"} * 100Aqui calculamos a porcentagem de tempo que a CPU está no modo "system" em relação ao tempo no modo "idle".

- Funções de agregação: Agrupam e resumem séries temporais. As funções incluem

sum(soma),avg(média),max(máximo),min(mínimo),count(contagem), entre outras. Por exemplo:

sum(rate(http_requests_total[5m])) by (job)Nesta consulta, calculamos a taxa de requisições HTTP nos últimos 5 minutos (rate(http_requests_total[5m])) e em seguida somamos por job, ou seja, obtemos a taxa total por job.

- Funções de filtro: Filtram séries temporais com base em valores ou labels. Por exemplo, a função

topk(5, metric)retorna as 5 séries com os maiores valores para a métrica especificada. Exemplo:

topk(5, http_requests_total)Isso retornará as 5 séries de http_requests_total com os maiores valores.

-

Funções de transformação: Transformam séries temporais de maneiras específicas. Exemplos incluem:

rate(): calcula a taxa de aumento por segundo de um contador (derivada primeira) em uma janela de tempo.irate(): similar aorate(), mas calcula a taxa instantânea entre os dois pontos de dados mais recentes.increase(): calcula o total acumulado que o contador aumentou durante o período.delta(): calcula a diferença absoluta entre o primeiro e o último valor em uma janela de tempo.histogram_quantile(): calcula um quantil (por exemplo, 0.95 para 95º percentil) a partir de um histograma.

Exemplo de transformação com

histogram_quantile:histogram_quantile(0.95, rate(http_request_duration_seconds_bucket[5m]))Acima, estamos calculando o 95º percentil da distribuição de duração de requisições HTTP nos últimos 5 minutos, usando as séries

_bucketdo histograma de duração. -

Expressões booleanas (comparações): Avaliam condições verdadeiras ou falsas sobre os valores de séries temporais. Os operadores de comparação incluem

==(igual),!=(diferente),>(maior que),<(menor que),>=(maior ou igual) e<=(menor ou igual). Por padrão, ao comparar duas séries, o resultado é uma série booleana (1 para true, 0 para false) apenas para as combinações de séries que correspondem exatamente nos labels (veremos mais sobre correspondência de vetores adiante). Também é possível usar o modificadorboolpara forçar o resultado booleano a ser retornado.Um exemplo de expressão booleana combinada com cálculo:

rate(http_requests_total{status_code=~"5.."}[1m])

> rate(http_requests_total{status_code=~"2.."}[1m]) * 0.1Esta consulta verifica se a taxa de requisições HTTP com códigos de status 5xx no último minuto é maior que 10% da taxa de requisições 2xx no mesmo período. O resultado será uma série temporal booleana indicando, para cada combinação de labels, se a condição é verdadeira (1) ou falsa (0). Essa abordagem é útil em alertas.

Vector vs. Range Vector

Em PromQL, existem dois tipos principais de vetor que podem ser retornados em consultas: Instant Vector (vetor instantâneo) e Range Vector (vetor de intervalo).

-

Instant Vector (Vetor Instantâneo): Representa um conjunto de amostras (valor + timestamp) de múltiplas séries temporais, todas no mesmo instante no tempo. Cada série temporal no resultado possui os mesmos labels originais e um único valor correspondente ao momento da avaliação. Por exemplo, a expressão

cpu_usage{instance="webserver-1"}retornaria, no momento atual, o valor mais recente da métricacpu_usagepara a instânciawebserver-1. -

Range Vector (Vetor de Intervalo): Representa um conjunto de séries temporais, onde cada série contém um conjunto de amostras dentro de um intervalo de tempo especificado. Em vez de um único valor, cada série traz todos os pontos (timestamp, valor) coletados naquele intervalo. Range vectors são obtidos usando a sintaxe

[<duração>]após um seletor de métrica. Por exemplo,cpu_usage{instance="webserver-1"}[5m]retorna os últimos 5 minutos de dados da métricacpu_usagepara a instânciawebserver-1. As funções comorate(),increase()eavg_over_time()tipicamente esperam um range vector como entrada.

Exemplos de uso de Instant e Range vectors:

- Selecionando o valor atual (instantâneo) da métrica

cpu_usagepara a instância"webserver-1":

cpu_usage{instance="webserver-1"}- Calculando a diferença instantânea entre duas métricas (Instant Vector resultante):

http_requests_total - http_requests_failedAcima, subtraímos, para cada combinação de labels correspondente, o valor atual de http_requests_failed do valor atual de http_requests_total.

- Selecionando uma janela de 5 minutos de dados da métrica

cpu_usagepara cada instância (Range Vector):

cpu_usage[5m]- Calculando a taxa (por segundo) de

cpu_usagenos últimos 5 minutos para cada instância (note querate()retorna um Instant Vector, com a taxa calculada para cada série):

rate(cpu_usage[5m])- Obtendo o valor máximo da métrica

network_trafficem um intervalo de 30 minutos, separado por instância:

max_over_time(network_traffic[30m]) by (instance)Resumindo: um Instant Vector é adequado para consultas que requerem o valor atual (ou de um instante específico) de uma métrica, enquanto um Range Vector é necessário para consultas que envolvem cálculo ao longo do tempo (taxas, médias móveis, etc.). Muitas funções do PromQL, como

rateeavg_over_time, só funcionam com range vectors porque precisam de vários pontos de dados para produzir um resultado.

Segurança do seletor (Seletores seguros vs inseguros)

Ao escrever consultas PromQL, é importante construir seletores de métricas que capturem exatamente as séries desejadas, evitando resultados imprecisos ou indesejados. Alguns seletores podem ser considerados “inseguros” porque podem abranger séries não pretendidas.

Por exemplo, usar uma correspondência de prefixo muito genérica em um label pode ser problemático. Considere o seletor de label job=~"prom.*". Ele selecionará todas as séries de métricas cujo label job começa com “prom”.

Isso pode incluir não apenas o job principal “prometheus”, mas também qualquer outro job cujo nome comece com essas letras (por exemplo, um serviço “promtail” ou “prometheus-exporter”). O resultado pode ser uma consulta retornando séries inesperadas.

Para garantir seletores “seguros”, siga algumas práticas:

- Seja explícito nos valores de label: Prefira usar correspondência exata (

=ou!=) ou regex precisas. Por exemplo, se você quer métricas do job Prometheus, usejob="prometheus"em vez de um regex genérico. - Evite padrões muito abrangentes: Como regra, só use regex se realmente precisar capturar múltiplos valores similares. Mesmo assim, tente restringir o padrão. Regex tendem a ser menos eficientes, pois precisam testar o padrão contra todos os valores conhecidos de um label, e podem indicar que talvez a configuração dos labels deva ser melhorada.

- Conheça seus labels: Entenda quais labels cada métrica possui e quais valores são possíveis. Isso ajuda a criar seletores que não tragam surpresas.

Exemplos comparando seletores seguros vs inseguros:

- Seguro:

http_requests_total{job="webserver", status="error"}– seleciona exatamente as séries de requisições HTTP do serviçowebserverque possuem o status “error”. - Inseguro:

http_requests_total{status=~"err.*"}– poderia acidentalmente pegar algo como “erroneous” ou “errata” se esses fossem valores de status, além de “error”. Prefirastatus="error"se é esse o valor exato desejado. - Seguro:

{__name__=~"^http_.*_total$"}– seleciona métricas cujo nome começa com “http_” e termina com “_total”. - Inseguro:

{__name__=~"http"}(sem âncoras ou wildcards definidos) – esse seletor está incompleto e potencialmente inválido. Sempre especifique padrões completos, por exemplohttp.*se a intenção é “começa com http”.

Em suma, construa seletores de forma cuidadosa para evitar incluir séries indesejadas. Isso garante que suas consultas retornem dados precisos e também evita sobrecarregar o Prometheus com resultados excessivos.

Obsolescência do vetor instantâneo (Staleness)

Um detalhe importante ao usar vetores instantâneos: o Prometheus possui um mecanismo de staleness (obsolescência) para lidar com séries temporais que não receberam novos dados em um intervalo de tempo.

Por padrão, se uma métrica não tiver amostras recentes (normalmente nos últimos 5 minutos), o PromQL considerará essa série como ausente ou retornará um valor NaN (not a number) em vez de continuar mostrando um valor antigo. Isso evita apresentar dados “velhos” como se fossem atuais.

Porém, em algumas consultas, especialmente ao criar alertas, queremos detectar explicitamente quando uma métrica parou de ser enviada. Existem maneiras de lidar com isso:

- Aumentar a janela de consulta: Em vez de consultar apenas o valor instantâneo, podemos consultar em uma janela de tempo para ver se há dados recentes. Por exemplo, usar uma subconsulta com intervalo:

http_requests_total[5m]garante que estamos inspecionando 5 minutos de dados. Ou então, usar funções como max_over_time(metric[5m]) para pegar o último valor nos últimos 5 minutos.

- Usar funções de ausência: O PromQL oferece a função

absent()que retorna 1 se a expressão dentro dela não retornar nenhum dado. Por exemplo:

absent(rate(http_requests_total[5m]))retornará 1 (com um label indicando a série buscada) se nenhuma série http_requests_total tiver dados nos últimos 5 minutos – ou seja, indicando que possivelmente a coleta parou. Caso exista qualquer dado, absent() retorna uma série vazia.

Também há a variante absent_over_time(metric[duração]), que verifica se no intervalo dado a métrica esteve ausente o tempo todo.

- Combinar com condições booleanas: Podemos filtrar séries pelo timestamp de sua última amostra. A função

timestamp(metric)retorna o timestamp da última amostra daquela métrica. Assim, expressões como:

timestamp(cpu_usage) < time() - 30identificam séries cujo último timestamp é inferior a 30 segundos atrás, ou seja, possivelmente desatualizadas.

Exemplos práticos:

- Verificar métricas ausentes:

http_requests_total unless absent(rate(http_requests_total[5m]))Aqui, usamos unless (que retorna a série da esquerda exceto quando a da direita existe) para só manter http_requests_total se ela não estiver ausente nos últimos 5m. Isso efetivamente filtra fora séries que não receberam dados recentes.

- Filtrar instâncias inativas (não reportando):

cpu_usage unless absent_over_time(cpu_usage[2m])Essa consulta retornaria cpu_usage atual apenas para instâncias que tiveram dados nos últimos 2 minutos. Se alguma instância parou de reportar (logo, ausente nos últimos 2m), ela será excluída do resultado.

- Combinar timestamp e booleano:

cpu_usage * on(instance) group_left() ((time() - timestamp(cpu_usage)) < 30)Esta expressão resulta no valor de cpu_usage apenas para instâncias cujo último timestamp tem menos de 30 segundos de idade. Estamos multiplicando o valor atual de cpu_usage por uma condição booleana que vale 1 apenas para instâncias atualizadas recentemente (e 0 para instâncias atrasadas).

O uso de * on(instance) group_left() garante que combinamos corretamente cada instância com sua condição booleana.

Em resumo, devido ao comportamento de staleness, um vetor instantâneo pode não mostrar valores de métricas atrasadas. Para contornar isso, podemos usar janelas de tempo maiores ou funções especiais como absent() para tratar casos de ausência de dados.

Funções Matemáticas e Clamping

As funções em PromQL permitem manipular e processar métricas de diversas formas. Dentre as mais comuns estão as funções matemáticas, que realizam operações aritméticas sobre as séries de métricas. Temos desde as operações básicas até funções matemáticas de biblioteca. Alguns exemplos:

sqrt(vector): retorna a raiz quadrada de cada valor no vetor.exp(vector): retorna o exponencial (e^x) de cada valor.ln(vector): logaritmo natural.log10(vector),log2(vector): logaritmos base 10 e base 2, respectivamente.ceil(vector),floor(vector): arredondamento para cima ou baixo.

Além disso, PromQL fornece funções para limitar valores extremos (clamping). As funções clamp_min(vector, scalar) e clamp_max(vector, scalar) limitam os valores de um vetor a um mínimo ou máximo especificado. Por exemplo:

clamp_min(metric, 0): garante que nenhum valor da sériemetricseja menor que 0 (valores negativos seriam substituídos por 0).clamp_max(usage_ratio, 1): garante que valores acima de 1 emusage_ratio(por exemplo, 100% de uso) sejam reduzidos para 1.

Essas funções de clamping são úteis para evitar que ruídos ou anomalias atrapalhem visualizações. Por exemplo, se um cálculo produz temporariamente um valor negativo ou um valor absurdamente alto por conta de algum atraso ou jitter, podemos usar clamping para limitar a escala dos gráficos.

Exemplos de uso de funções matemáticas e clamping:

- Calcular a média dos valores de uma métrica nos últimos 5 minutos:

avg_over_time(metric_name[5m])- Calcular a soma dos valores de uma métrica nos últimos 10 minutos:

sum_over_time(metric_name[10m])- Calcular o máximo valor de uma métrica nos últimos 1 hora, filtrando por um label:

max_over_time(metric_name{label="value"}[1h])- Limitar o valor de uma métrica entre 0 e 100:

clamp_min(clamp_max(metric_name, 100), 0)(Aplica clamp_max para limitar a 100 e depois clamp_min para garantir mínimo 0.)

- Converter uma fração em porcentagem e garantir que não passe de 100%:

clamp_max(success_ratio * 100, 100)Supondo que success_ratio seja uma métrica ou expressão que resulta em um valor entre 0 e 1 (por exemplo, proporção de sucesso), multiplicamos por 100 para obter porcentagem e usamos clamp_max para nunca exibir acima de 100%.

Conhecer e utilizar essas funções permite realizar consultas mais avançadas e obter insights mais precisos a partir dos dados coletados.

Timestamps e Funções de Tempo e Data

No PromQL, timestamps (carimbos de tempo) são representados internamente como números de ponto flutuante indicando segundos desde a época Unix (1º de janeiro de 1970, 00:00:00 UTC).

Embora normalmente não precisemos lidar diretamente com o valor numérico do timestamp, há funções úteis relacionadas ao tempo:

-

time(): retorna o timestamp Unix do momento atual (momento da avaliação da consulta). Pode ser utilizado, por exemplo, para calcular diferenças de tempo. Exemplo:time() - 3600produziria um valor de timestamp correspondente a uma hora atrás. -

timestamp(vetor): retorna, para cada série no vetor dado, o timestamp da última amostra daquela série. Útil para comparações e detecção de desatualização (como visto anteriormente).

Além disso, existem funções para extrair componentes de data/hora do timestamp de cada amostra de uma série:

day_of_week(vetor): retorna o dia da semana (0–6, onde 0 = domingo, 1 = segunda, etc.) de cada amostra no vetor dado.hour(vetor): retorna a hora (0–23) do timestamp de cada amostra.day(vetor),month(vetor),year(vetor): retornam respectivamente o dia do mês, o mês (1–12) e o ano do timestamp de cada amostra.

Essas funções permitem criar consultas que dependem da hora ou dia. Por exemplo, você pode querer detectar padrões diurnos ou disparar alertas apenas em dias úteis.

Exemplos de uso de funções de tempo e data:

- Obter o timestamp atual (como escalar):

time()- Extrair a hora atual do dia como um valor (0–23):

hour(vector( time() ))Aqui, vector(time()) converte o escalar retornado por time() em um vetor (necessário porque hour() espera um vetor). O resultado é um vetor com um único valor: a hora do dia.

- Calcular a média de uma métrica por hora do dia, nos últimos 24h (usando subconsulta para separar por hora):

avg_over_time(my_metric[1h])[24h:1h]Essa expressão é uma subconsulta que calcula avg_over_time(my_metric[1h]) (média de my_metric em cada janela de 1h) para cada hora nas últimas 24 horas. Isso produz uma série de 24 pontos, um para cada hora, que pode ser útil para observar a variação horária.

- Selecionar o valor médio da métrica

my_metricno último dia:

avg_over_time(my_metric[1d])(Assumindo que há dados suficientes para cobrir o último dia inteiro.)

- Nota: Para consultar um período específico (entre timestamps específicos), não há uma sintaxe direta dentro do PromQL. Em vez disso, usa-se a API de consulta de intervalos do Prometheus (fornecendo

starteendno request) ou ferramentas como Grafana para delimitar visualmente o período. Dentro do PromQL, operações de tempo são relativas (como “últimos 5 minutos”, “últimas 24h”, etc.) em relação ao momento de avaliação.

Counter Range Vectors, Agregação Temporal e Subconsultas

Counter Range Vectors: Contadores são métricas que apenas aumentam (ou resetam para zero e voltam a aumentar). Exemplos: número total de requisições atendidas, bytes transferidos, etc. Quando consultamos diretamente um counter como range vector, obteremos uma série de pontos que só crescem (com eventuais resets). Para extrair informações úteis (como taxa de eventos por segundo ou aumentos em determinado período) usamos funções especiais:

rate(counter[5m]): Calcula a taxa média por segundo de incremento do contador nos últimos 5 minutos. Essa função já lida corretamente com resets do contador (ignorando as quedas abruptas devido a resets e calculando a taxa considerando isso).irate(counter[5m]): Calcula a taxa instantânea (baseada apenas nos dois pontos mais recentes dentro dos 5 minutos). É mais ruidosa, mas pode reagir mais rapidamente a mudanças repentinas.increase(counter[1h]): Calcula quanto o contador aumentou no último 1 hora. Essencialmente integra a taxa ao longo do período.

Agregação através do tempo (Aggregating Across Time): Às vezes, queremos primeiro agregar os dados e depois analisar a evolução temporal dessa agregação. As subconsultas nos permitem isso. Uma subquery (subconsulta) é quando temos uma expressão do PromQL seguida de um intervalo entre colchetes e possivelmente uma resolução, por exemplo: expr[duração:passo]. Isso faz o Prometheus avaliar expr repetidamente ao longo do intervalo dado, produzindo um range vector como resultado.

Por exemplo, avg_over_time(rate(http_requests_total[1m])[24h:1h]) funciona assim:

- Internamente,

rate(http_requests_total[1m])é avaliado para cada passo de 1h dentro das últimas 24h, gerando a taxa média por minuto calculada a cada hora. - Em seguida,

avg_over_time(...[24h:1h])calcula a média desses 24 valores (um por hora) no tempo atual. Na prática, isso nos daria a média da taxa horária de requisições no dia.

Subconsultas são muito poderosas e foram aprimoradas a partir do Prometheus 2.7. Com elas é possível, por exemplo, calcular tendências, baselines e sazonalidade de forma compacta.

Exemplos avançados de subconsultas e análise de tendências:

- Tendência de taxa de erro (janela móvel): Calcular a média da taxa de erros em janelas de 1 hora, ao longo das últimas 24 horas:

avg_over_time(

rate(http_requests_total{status=~"5.."}[1m])[24h:1h]

)Essa consulta gera 24 pontos (taxa de erro média de cada hora nas últimas 24h) e depois calcula a média disso tudo (ou seja, a média diária da taxa de erro). Poderíamos também omitir a função externa para simplesmente visualizar a série das últimas 24 horas e identificar padrões de aumento ou redução de erros ao longo do dia.

- Baseline de performance (comparação com média histórica): Comparar a performance atual com a média da última semana:

rate(http_requests_total[5m])

/ avg_over_time(rate(http_requests_total[5m])[7d])Essa consulta produz uma razão: valores acima de 1 indicam que a taxa atual de requisições está acima da média semanal; valores abaixo de 1, abaixo da média. Isso pode ser útil para identificar desvios significativos de tráfego.

- Detecção de anomalia sazonal (padrão horário): Comparar o tráfego atual com o padrão do último dia:

rate(http_requests_total[5m])

/ avg_over_time(rate(http_requests_total[5m])[24h:1h])Aqui, o denominador avg_over_time(...[24h:1h]) produz a média da taxa em cada hora do dia anterior. Dividindo a taxa atual por esse valor da mesma hora ontem, podemos identificar se o tráfego está anormalmente alto ou baixo para este horário do dia.

- Diferença diária (subconsulta com offset): Para calcular a diferença em uma métrica entre hoje e ontem, podemos usar

offset. Exemplo:

my_metric - my_metric offset 1dIsso resulta em quanto my_metric variou em comparação com exatamente 24 horas atrás.

- Soma acumulada (exemplo de subconsulta):

sum(my_counter) - sum(my_counter) offset 1dEste exemplo soma o contador my_counter (provavelmente de várias instâncias) e subtrai o valor de 1 dia atrás, mostrando o incremento total em um dia. Essa é outra forma de calcular algo similar a increase(my_counter[1d]).

Em todos esses casos, as subconsultas [ ... ] estão permitindo observar ou reutilizar resultados ao longo do tempo dentro de uma única expressão.

Histogramas, Mudança de Tipo, Alteração de Labels e Ordenação

Histogramas: Em Prometheus, histogramas são uma forma de metricar distribuições de valores (duração de requisições, tamanho de payloads, etc.). Um histograma clássico consiste em múltiplas séries: por convenção, se a métrica base é request_duration_seconds, as séries serão:

request_duration_seconds_bucket{le="0.1", ...}(um bucket contando quantas observações <= 0.1s)- vários outros buckets com diferentes limites

le(le = limite inferior ou igual) request_duration_seconds_count(contagem total de observações)request_duration_seconds_sum(soma total dos valores observados)

Para analisar histogramas, geralmente somamos as séries _bucket por limite para agregar todas as instâncias ou rótulos de interesse. É crucial incluir o label le ao agregar buckets. Por exemplo, a forma correta de agregar um histograma de duração por job seria:

sum by (job, le) (rate(http_request_duration_seconds_bucket[5m]))Depois de agregado adequadamente, podemos aplicar histogram_quantile() para extrair quantis (p50, p90, p99, etc.).

Trabalhando corretamente com histogramas:

- Exemplo canônico (p99 de latência HTTP):

histogram_quantile(

0.99,

sum(rate(http_request_duration_seconds_bucket[5m])) by (le)

)Esse retorna o 99º percentil da duração das requisições HTTP considerando todos os buckets. Note o uso de by (le) dentro do sum.

- Agregando por labels extras: Se quisermos o percentil por

jobeinstance, por exemplo, devemos manter esses labels na agregação, além dole:

histogram_quantile(

0.95,

sum(rate(http_request_duration_seconds_bucket[5m])) by (job, instance, le)

)-

Evitando erro comum: Nunca esqueça o

by (le)ao somar buckets de um histograma clássico. Por exemplo, isto está errado:# Exemplo INCORRETO - ausência de by(le) histogram_quantile(0.95, sum(rate(http_request_duration_seconds_bucket[5m])))

Sem agrupar por le, os valores de buckets se somam indevidamente, tornando o resultado do quantil incorreto.

No Prometheus 3.0, foram introduzidos os histogramas nativos (ainda experimentais). Eles visam simplificar e tornar mais eficiente o uso de histogramas (evitando lidar com dezenas de séries _bucket).

Com histogramas nativos, existem inclusive novas funções como histogram_count(), histogram_sum() e histogram_avg() para extrair diretamente contagem, soma e média dos histogramas.

Além disso, há a função histogram_fraction() para calcular frações entre limites. Embora seja um recurso promissor, a maioria dos usuários ainda trabalha com histogramas clássicos _bucket até que os nativos se estabilizem.

Mudança de tipo (conversão Escalar <-> Vetor): Em algumas situações avançadas, você pode precisar converter escalares em vetores ou vice-versa:

scalar(vetor)– Converte um vetor de uma única série temporal (com um único valor) em um escalar simples. Isso é útil, por exemplo, quando você calculou um valor mínimo ou máximo e quer usá-lo em uma comparação global. Exemplo:scalar(min(up{job="webserver"}))– isso resultará em um escalar 0 ou 1 indicando se alguma instância do job “webserver” está caída (0 se o mínimo for 0, ou seja, pelo menos uma instância está down; 1 se todas estão up).vector(escalar)– O oposto, pega um escalar e o transforma em um vetor (sem labels). Útil se você precisa combinar um número puro com séries. Exemplo:vector(1)– produziria um vetor contendo apenas o valor 1.

Alteração de Labels: Às vezes é necessário renomear ou copiar labels nas séries. Funções úteis:

label_replace(vetor, "label_destino", "valor_novo", "label_origem", "regex")– Retorna um vetor a partir de outro, adicionando ou modificando um label. Ele pega o valor dolabel_origemque case com a regex fornecida e o coloca emlabel_destinousandovalor_novo(onde'$1'pode referenciar grupos da regex). Exemplo:

label_replace(my_metric, "new_label", "$1", "old_label", "(.*)")Isso criaria (ou sobrescreveria) new_label em cada série de my_metric, copiando exatamente o valor de old_label (já que (.*) captura todo o valor e $1 insere ele).

label_join(vetor, "label_destino", "sep", "label1", "label2", ...)– Concatena múltiplos labels em um só. Ex:label_join(my_metric, "instance_job", "-", "instance", "job")criaria um novo labelinstance_jobjuntando os valores deinstanceejobseparados por um-.

Essas funções não são usadas com frequência em consultas ad-hoc, mas podem ser muito úteis ao preparar métricas para certas comparações ou ao lidar com diferenças de rotulagem entre métricas.

Ordenação (Sorting): Para ordenar resultados, podemos usar as funções sort(vector) (ordem crescente) e sort_desc(vector) (ordem decrescente). Isso pode ser útil quando estamos interessados no topo ou no final de uma lista de resultados (embora muitas vezes topk e bottomk já cubram esses casos).

Exemplos rápidos:

-

Ordenar todas as instâncias pelo uso de CPU decrescente:

sort_desc(rate(node_cpu_seconds_total{mode!="idle"}[5m])) by (instance))(Aqui somamos as CPUs por instância implicitamente ao usar o

by (instance)na expressão, e depois ordenamos.) -

Ordenar alfabéticamente por valor de um label (pouco comum, mas possível):

sort(my_metric)(Se

my_metricé um escalar ou tem apenas um valor por série,sort()essencialmente ordenará pelos labels já que os valores podem ser iguais.)

Valores ausentes (Absent / Missing Values)

Valores ausentes podem ocorrer quando uma métrica não é reportada (por exemplo, um serviço caiu ou foi desligado). Em consultas PromQL, um valor ausente simplesmente não aparece no resultado. Entretanto, podemos detectar explicitamente a ausência de séries usando a função absent() mencionada anteriormente.

Recapitulando o uso de absent():

absent(metric)– Retorna uma série sem labels (ou com labels especificados na consulta) com valor 1 se nenhuma série correspondente ametricestá presente, ou retorna nada (vazio) caso contrário. Isso é muito útil em regras de alerta: um alerta de “TargetDown” pode ser escrito comoabsent(up{job="myjob"} == 1)para disparar quando nenhum alvo daquele job estiver up.

Exemplo:

absent(up{job="node"} == 1)Acima, a expressão up{job="node"} == 1 resultaria em 1 para cada instância de node que esteja up, então absent(...) retornaria 1 (sem label) se nenhuma instância de node estiver up (ou seja, o resultado dentro foi vazio). Se pelo menos uma instância estiver up, absent não retorna nada.

Da mesma forma, absent_over_time(metric[5m]) verifica se nenhum ponto de metric apareceu nos últimos 5 minutos.

Importante: Ao visualizar dados no gráfico do Prometheus ou Grafana, séries ausentes simplesmente não aparecem. Por isso, ao compor dashboards ou alertas, pode ser útil usar consultas que retornem 0 explicitamente quando algo está ausente para facilitar a visualização. Uma técnica é usar a operação OR com absent(). Exemplo:

rate(http_requests_total[5m]) or absent(http_requests_total)Isso retornará a taxa de requisições normalmente; se nenhuma série existir, em vez de nada, retornará 1 (ou outro valor constante) indicando ausência.

Funções avançadas e menos conhecidas

Algumas funções do PromQL são menos conhecidas, mas podem ser extremamente poderosas em cenários específicos:

-

resets(counter[interval]): Conta quantas vezes um contador “resetou” (voltou a zero) no período. Útil para detectar reinicializações de aplicativos ou problemas de coleta. Exemplos:resets(http_requests_total[5m])Contaria quantos resets ocorreram no

http_requests_totalnos últimos 5 minutos. Se esse número for > 0 constantemente, pode indicar que o serviço está reiniciando frequentemente (se o contador for interno ao serviço) ou que há overflow de contadores. -

changes(series[interval]): Conta quantas vezes o valor de uma série mudou durante o intervalo. Isso vale para qualquer métrica (não apenas counters). Pode indicar instabilidade ou flapping. Exemplo:changes(process_start_time_seconds[5m]) > 0O exemplo acima retornaria 1 para instâncias cujo

process_start_time_seconds(normalmente um timestamp de início do processo) tenha mudado nos últimos 5 minutos — ou seja, o processo reiniciou nesse período. -

predict_linear(series[interval], passos_no_futuro): Realiza uma extrapolação linear do valor da série com base na tendência nos últimos intervalos e prevê o valor daqui a X segundos (informado empassos_no_futuro). Útil para prever quando algo alcançará um certo limite. Exemplo:predict_linear(node_filesystem_free_bytes[1h], 3600) < 0Poderia ser usado para alertar se a tendência de queda do espaço livre prevê que em 1 hora (

3600segundos) o espaço chegaria a zero. -

holt_winters(series[interval], sf, tf): Embora mais comum no Graphite, o PromQL também tem uma função de previsão chamadaholt_winters(Holt-Winters, série temporal com tendência e sazonalidade). Aceita uma série (geralmente resultado de subconsulta) e realiza suavização exponencial dupla. No entanto, essa função é raramente usada diretamente em alertas, servindo mais para visualização de tendências suavizadas. -

Funções para histogramas nativos (Prometheus 3.x):

histogram_count()ehistogram_sum()– Retornam, respectivamente, a contagem total e a soma total das observações de histogramas (clássicos ou nativos). Para histogramas clássicos, esses usam as séries_counte_suminternas; para nativos, usam os valores codificados.histogram_avg()– Computa a média dos valores observados em cada histograma, equivalente ahistogram_sum/histogram_count.histogram_fraction(lower, upper, hist)– Estima a fração de observações dentro do intervalo[lower, upper]para cada histograma. Útil, por exemplo, para calcular Apdex (fração de requisições abaixo de um certo limiar de latência).

Lembrando que algumas dessas funções mais novas podem requerer flags experimentais, dependendo da versão do Prometheus.

Operadores Aritméticos e Correspondência de Vetores Simples

PromQL permite usar operadores binários entre séries temporais para calcular novas séries. Os operadores aritméticos são: +, -, *, /, % (módulo) e ^ (exponenciação). Eles podem operar entre:

- Escalar e escalar (ex.:

2 * 3) - Vetor e escalar (o escalar aplica-se a todos os valores do vetor; ex.:

metric * 100) - Vetor e vetor (aqui entra o conceito de correspondência de vetores)

Quando aplicamos um operador entre dois vetores (Instant Vectors), o PromQL realiza a operação par a par entre séries que “correspondem” umas às outras. Essa correspondência por padrão requer que as séries tenham exatamente os mesmos labels (nome da métrica pode ser diferente, mas os rótulos-chave e seus valores devem coincidir).

Exemplo simples: se temos as séries metric_a{host="A", env="prod"} com valor X e metric_b{host="A", env="prod"} com valor Y, então metric_a + metric_b retornará {host="A", env="prod"} com valor X+Y. Se não houver correspondência exata de labels entre alguma série de metric_a e alguma de metric_b, aquela combinação não aparece no resultado.

Correspondência simples: Por padrão, todos os labels (exceto o nome da métrica) devem casar entre as duas séries para a operação acontecer. É possível ajustar isso com modificadores que veremos adiante (on e ignoring).

Se quisermos forçar a operação em todas as combinações (o que raramente faz sentido), há o modificador cross_join (PromQL >2.9), mas geralmente ele não é utilizado porque o comportamento padrão já é suficiente.

Os operadores também podem ser usados com o modificador bool, mas isso só se aplica a operadores de comparação, não aos aritméticos.

Exemplos práticos de operadores aritméticos:

-

Soma de métricas:

http_requests_total{status="200"} + http_requests_total{status="500"}Aqui, somamos as séries de requisições com status 200 e as com status 500, casando por quaisquer outros labels (por exemplo, instância). O resultado é o total combinado de requisições de sucesso e erro.

-

Diferença de métricas:

node_memory_MemTotal_bytes - node_memory_MemFree_bytesCalcula a memória em uso (diferença entre total e livre) para cada instância, assumindo que ambas as métricas compartilham os labels de instância.

-

Multiplicação por escalar:

cpu_usage * 100Converte a métrica

cpu_usage(talvez como fração 0–1) em porcentagem. -

Combinação de dois vetores diferentes:

errors_total / requests_totalPode calcular a taxa de erro (assumindo que

errors_totalerequests_totalcompartilham labels como serviço/endpoint). Isso exige correspondência exata de labels.

No caso acima, se errors_total existir para um determinado label e requests_total não, essa combinação não retorna resultado. Podemos usar vector matching avançado (próxima seção) para ajustar essas situações.

Correspondência de Séries Temporais: on(), ignoring(), group_left, group_right

Quando combinamos métricas diferentes (vetor-vetor), muitas vezes precisamos controlar quais labels são usados para fazer o join (união) entre as séries de cada lado da operação. É aqui que entram os modificadores on e ignoring, e os operadores de junção externa group_left e group_right:

-

on(lista_de_labels): Especifica explicitamente quais labels devem ser usados para casar as séries ao aplicar o operador. Todos os demais labels são ignorados no matching (exceto os doonlistados). Exemplo:errors_total / on(instance) requests_totalAqui dizemos: combine séries de

errors_totalerequests_totalque tenham o mesmo valor deinstance. Labels diferentes deinstanceserão ignorados na comparação. Isso é útil se, por exemplo,errors_totaltem um labelstatus="5xx"enquantorequests_totalnão tem o labelstatus. Sem oon(instance), essas séries não casariam por terem conjuntos de labels distintos. -

ignoring(lista_de_labels): O inverso doon. Use todos os labels exceto os listados para fazer o matching. Ou seja, finge que os labels mencionados não existem nos vetores ao procurar pares correspondentes. Exemplo:cpu_usage{cpu="total"} / ignoring(cpu) cpu_quotaSuponha que

cpu_usagetenha um labelcpu(núcleo) e valor"total"para indicar uso total da CPU, enquantocpu_quotanão tem esse label (aplica a todo CPU). Oignoring(cpu)permite desconsiderar essa diferença, casando as séries somente pelos outros labels (por exemplo, pod ou contêiner, se for o caso). -

Junções um-para-muitos (many-to-one): Por padrão, se houver múltiplas séries de um lado que poderiam casar com uma série do outro, a operação não ocorre e o resultado é vazio para evitar ambiguidades. No entanto, às vezes desejamos permitir isso — por exemplo, dividir uma métrica total por número de CPUs, onde a métrica total não tem o label

cpumas a de contagem de CPU tem (múltiplas séries, uma por core). Para isso, usamosgroup_leftougroup_rightem conjunto comon/ignoring:group_left(label1, label2, ...): Indica que as séries do lado esquerdo do operador devem permanecer separadas (muitas) enquanto as do lado direito serão “espalhadas” para casar. Em outras palavras, permite que uma única série do lado direito seja usada para múltiplas do lado esquerdo. Opcionalmente, podemos listar labels que serão copiados do lado direito para o resultado final.group_right(label1, label2, ...): O contrário, mantém o lado direito com muitas séries e espalha o lado esquerdo.

Exemplo (adicionando labels com group_left):

rate(http_requests_total[5m]) * on(instance) group_left(job, environment) upNesse exemplo,

rate(http_requests_total[5m])produz séries talvez com labelsinstancee outros, mas digamos que não tenhajobnemenvironmentexplicitamente (ou queremos copiar doup). A sérieup(métrica de saúde do alvo) temjob,instance, eenvironment. Estamos multiplicando as duas métricas apenas casando porinstance(on(instance)). Como do lado direito (up) há possivelmente apenas uma série por instance (valor 0 ou 1), e do lado esquerdo pode haver múltiplas (por caminho de requisição, status, etc.), usamosgroup_left(job, environment)para dizer: permite que a mesma série deupcase com múltiplas séries de requests do lado esquerdo, e traga os labelsjobeenvironmentdessa série deuppara o resultado final. Assim, o resultado terá a taxa de requests porinstancemas agora enriquecido com os labels de job e environment.Exemplo (many-to-one sem copiar labels):

cpu_usage / on(instance) group_right cpu_countSuponha que

cpu_usage{instance="A"}representa o uso total de CPU (consolidado) em determinada máquina, ecpu_count{instance="A", cpu="0"}ecpu_count{instance="A", cpu="1"}etc. representam 1 para cada CPU física (cada core). Se somarmoscpu_count by (instance)obteríamos o número de CPUs por instância, mas podemos diretamente dividir usando o truque dogroup_right. Aqui, cada série decpu_usage(uma por instancia) será comparada com múltiplas séries decpu_count(uma por CPU). Semgroup_right, não casaria por haver múltiplas séries do lado direito para o mesmo instance. Comgroup_right, permitimos isso e, por não especificar labels a copiar, o resultado herda os labels do lado esquerdo (cpu_usage), e a operação divisão é feita para cada combinação (na prática repetindo o mesmo valor decpu_usagepara cada CPU e dividindo por o respectivocpu_count– o que acaba resultando no mesmo valor para cada CPU). Talvez nesse caso específico fosse melhor já agruparcpu_countantes de dividir, mas esse exemplo ilustra a sintaxe. -

Operador de conjunto

union: PromQL não possui um operador explícito “UNION” nomeado, mas podemos realizar união de resultados simplesmente listando expressões separadas por vírgula em uma consulta. Por exemplo:metric_a, metric_bIsso retorna todas as séries de

metric_ae todas as demetric_b. Não é muito comum em consultas manuais, mas pode ser útil para junção visual.

Resumindo, os modificadores on e ignoring controlam quais labels considerar ao casar séries de métricas diferentes, e group_left/group_right controlam como lidar quando há cardinalidades diferentes (um-para-muitos). Combiná-los corretamente é fundamental para escrever consultas que envolvam múltiplas métricas.

Operadores Lógicos: and, or, unless

Além dos operadores aritméticos e de comparação, PromQL também suporta operadores lógicos para vetores. Esses operadores não criam valores numéricos novos, mas sim filtram ou combinam séries com base em condições booleanas.

-

and: Retém apenas as séries que aparecem em ambos os operandos. Em outras palavras, é uma interseção: uma série do lado esquerdo só passa se existe uma série exatamente igual do lado direito (considerando labels) e vice-versa. O valor resultante de cada série será o valor do lado esquerdo (padrão) ou, se usado como comparador, segue regras de comparador bool. Uso típico: aplicar uma condição a um resultado. Por exemplo:(vector1 comparacao const) and vector1Isso retornaria apenas as séries de

vector1que atendem à comparação (pois o comparador produzirá 1 para as séries que satisfazem, e entãoandmanterá apenas essas). -

or: União de séries. Retorna séries que estão em pelo menos um dos lados. Se a mesma série (mesmos labels) aparece em ambos, o valor resultante será o do lado esquerdo (padrão) ou pode ser modificado com bool se estivermos combinando booleanos. É útil para combinar resultados diferentes. Por exemplo:vector_a or vector_bIsso dá todas as séries de

vector_aevector_b. Se alguma série estiver presente nos dois, aparece uma vez só (com valor devector_a). -

unless: Retém as séries do lado esquerdo a menos que elas também apareçam no lado direito. Equivale a diferença de conjuntos: resultado = esquerda \ direita. (Obs: O lado direito só importa pelos labels, seus valores são ignorados). Por exemplo:up{job="api"} unless up{job="api", region="us-east"}Isso retornaria as séries

updo job “api” que não têm region=“us-east”, ou seja, efetivamente filtra fora todas as instâncias da região us-east.

Os operadores lógicos são avaliados após todos os cálculos numéricos serem feitos. Isso significa que podemos usá-los tanto em métricas brutas quanto em resultados de expressões.

Exemplos práticos combinando comparações e operadores lógicos:

-

Contar instâncias ativas em dois grupos diferentes:

sum(up{job="node"} == 1) or sum(up{job="db"} == 1)Esse exemplo usa

== 1para converter as sériesupem booleanas (1 para up, 0 para down) e soma para contar quantas estão up em cada job. Ooraqui faz a união, retornando duas séries (uma para node e outra para db) com o valor de quantas instâncias estão up em cada. -

Filtrar top 5 de um conjunto e combinar com outro critério:

topk(5, rate(http_requests_total[5m])) and ignoring(instance) (rate(errors_total[5m]) > 0)Esse exemplo hipotético pegaria as 5 maiores taxas de requisição (independente de instância) e então, através do

andcomignoring(instance)e a condição de erros, manteria somente aquelas cujo serviço (ignorando instâncias) está apresentando erros. Bastante específico, mas demonstra o uso combinado:topkproduz séries; a outra parte produz 1/0 para serviços com erro; oand ignoring(instance)casa por serviço e filtra.

Lembrando que, se quisermos comparar valores de uma série com um número e obter diretamente 1 ou 0, podemos usar o modificador bool. Exemplo: vector1 > bool 10 retornaria um vetor com valor 1 para séries onde vector1 > 10 e 0 caso contrário (mantendo os labels). Sem bool, ele retornaria as próprias séries (com seus valores originais) porém filtradas pelas que atendem à condição.

Resumo de operadores de conjunto (conjuntos de séries)

Já falamos sobre on, ignoring, group_left, group_right e os operadores lógicos. Vale reforçar: